量子计算机(英语:Quantum computer;量子计算机)是一种使用量子逻辑进行通用计算的设备。不同于电子计算机(或称传统计算机),量子计算用来存储数据的对象是量子比特,它使用量子算法来进行数据操作。马约拉纳费米子的反粒子就是自己本身的属性,或许是令量子计算机的制造变成现实的一个关键。[1]量子计算机在舆论中有时被过度渲染成无所不能或速度快数亿倍等,其实这种计算机是否强大极度看问题而定,若该问题已经有提出速算的量子算法只是困于传统计算机无法运行,那量子计算机确实能达到未有的高速,若是没有发明算法的问题则量子计算机表现与传统无异甚至更差。

随着计算机科学的发展,斯蒂芬·威斯纳在1969年最早提出“基于量子力学的计算设备”。而关于“基于量子力学的信息处理”的最早文章则是由亚历山大·豪勒夫(1973)、帕帕拉维斯基(1975)、罗马·印戈登(1976)和尤里·马尼(1980)年发表[3][4][5][6]。斯蒂芬·威斯纳的文章发表于1983年[7]。1980年代一系列的研究使得量子计算机的理论变得丰富起来。1982年,理查德·费曼在一个著名的演讲中提出利用量子体系实现通用计算的想法。紧接着1985年大卫·杜斯提出了量子图灵机模型[8]。人们研究量子计算机最初很重要的一个出发点是探索通用计算机的计算极限。当使用计算机模拟量子现象时,因为庞大的希尔伯特空间而资料量也变得庞大。一个完好的模拟所需的运算时间则变得相当长,甚至是不切实际的天文数字。理查德·费曼当时就想到如果用量子系统所构成的计算机来模拟量子现象则运算时间可大幅度减少,从而量子计算机的概念诞生。半导体靠控制集成电路来记录及运算信息,量子计算机则希望控制原子或小分子的状态,记录和运算信息。

量子计算机在1980年代多处于理论推导状态。1994年彼得·秀尔提出量子质因数分解算法后[9],证明量子计算机能做出离散对数运算[10],而且速度远胜传统计算机。因为量子不像半导体只能记录0与1,可以同时表示多种状态。如果把半导体比喻成单一乐器,量子计算机就像交响乐团,一次运算可以处理多种不同状况,因此,一个40比特的量子计算机,就能在很短时间内解开1024位计算机花上数十年解决的问题。因其对于现在通行于银行及网络等处的RSA加密算法可以破解而构成威胁之后,量子计算机变成了热门的话题,除了理论之外,也有不少学者着力于利用各种量子系统来实现量子计算机。

什么是量子?

“量子计算”中的量子是指系统用来计算输出的量子力学。在物理学中,量子是所有物理特性的最小离散单元。它通常指原子或亚原子粒子(如电子、中微子和光子)的属性。

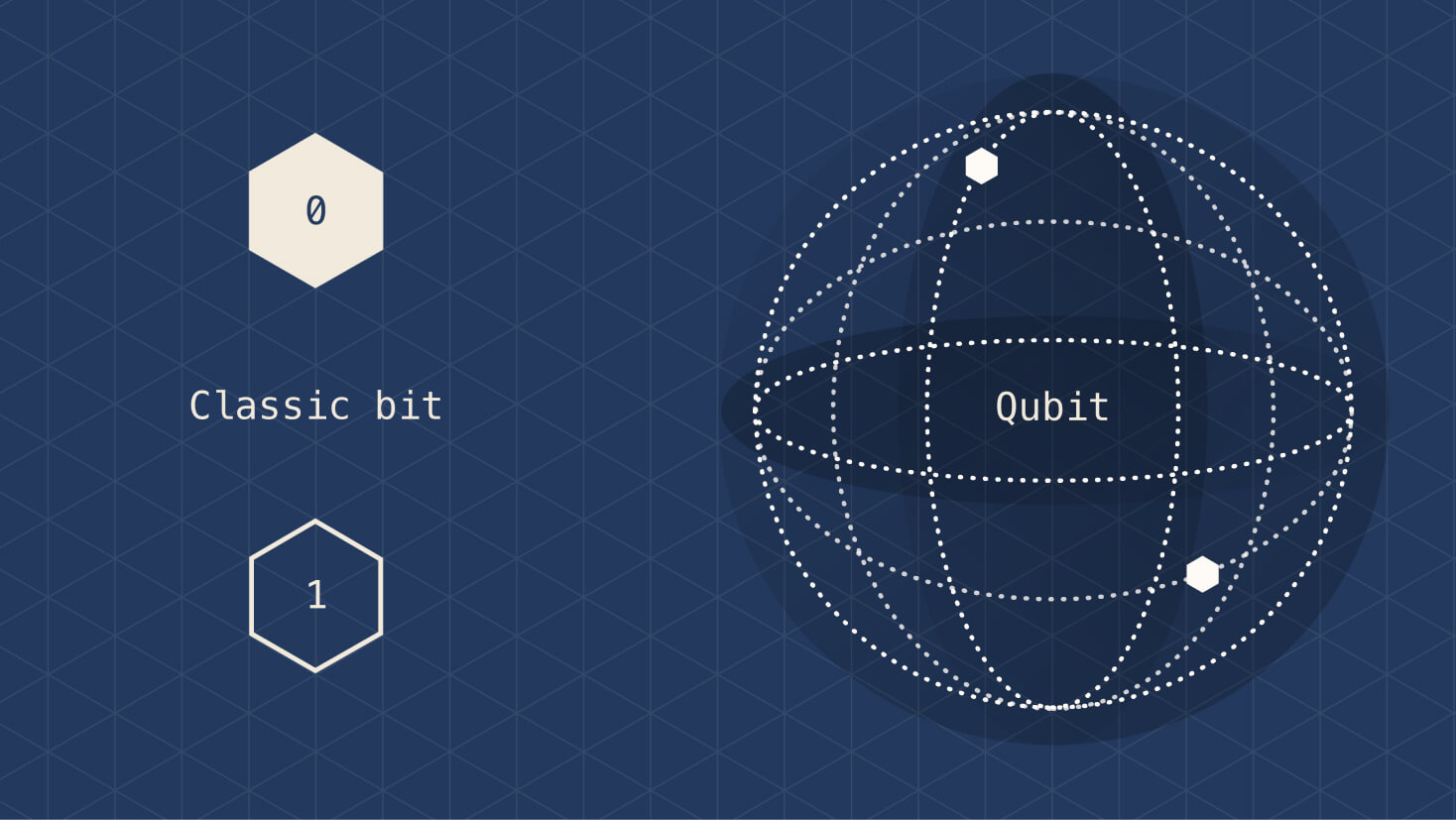

什么是量子比特?

量子比特是量子计算中的基本信息单位。量子比特在量子计算中发挥的作用与比特在传统计算中发挥的作用相似,但它们的行为方式却大相径庭。经典比特是二进制,只能存放 0 或 1 位,但量子比特可以存放所有可能状态的叠加。

量子位

什么是量子计算?

量子计算机可以利用量子力学的独特行为(如叠加、纠缠和量子干扰)并将其应用于计算。这为传统编程方法引入了新的概念。

叠加

处于叠加态时,量子粒子是所有可能状态的组合。它们会不断波动,直到被观察和测量。要了解二进制位与叠加之间的差异,一种方法是想像一枚硬币。经典比特通过“抛硬币”得到“正面”和“反面”来度量。但如果你能同时看到一枚硬币的正反面,以及正反交替时的每个状态,硬币就处于叠加态。

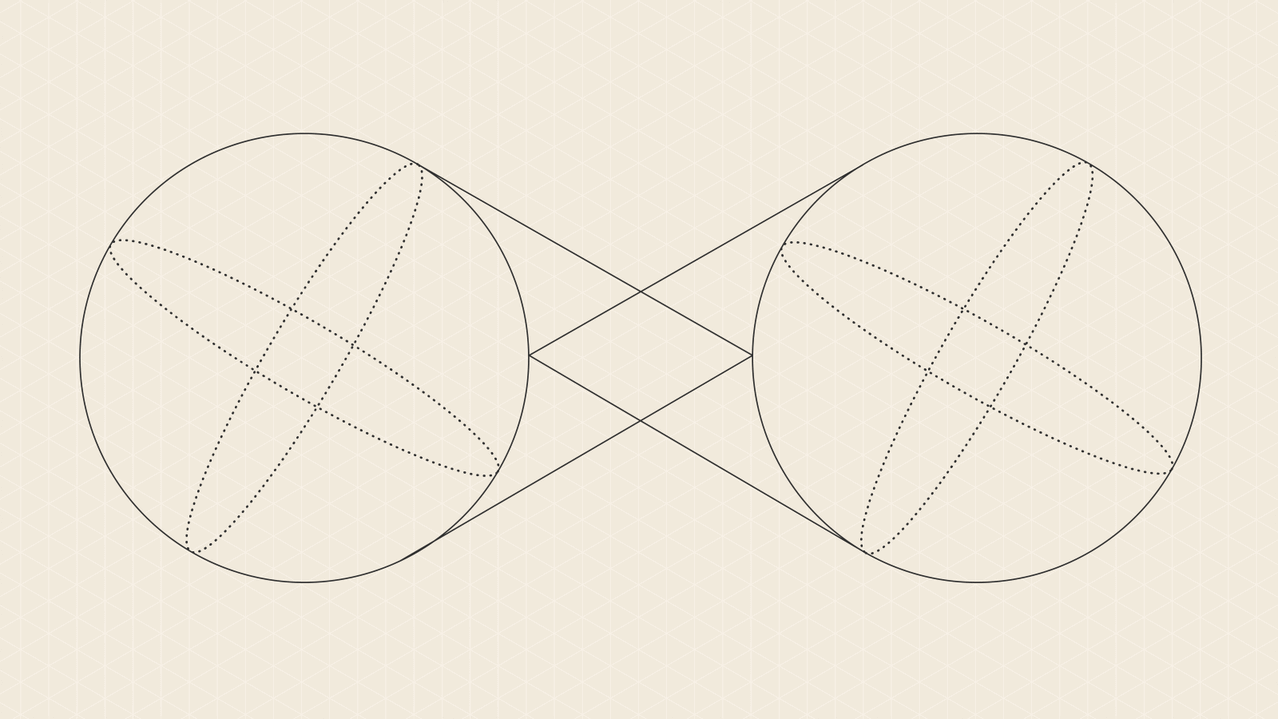

纠缠

纠缠是量子粒子将其测量结果相互关联的能力。当量子比特相互纠缠时,它们构成一个系统并相互影响。我们可以使用一个量子比特的度量来作出关于其他量子比特的结论。通过在系统中添加和纠缠更多的量子比特,量子计算机可计算指数级的更多信息并解决更复杂的问题。

量子干扰

量子干扰是量子比特固有的行为,由于叠加而影响其坍缩方式的可能性。量子计算机旨在尽可能减少干扰,确保提供最准确的结果。为此,Microsoft 使用拓扑量子比特,通过巧妙地处理其结构,并使用防止量子比特受外部干扰的化合物环绕量子比特,保持其稳定性。

量子计算的工作原理是什么?

量子计算机有三个主要部分:

- 承载量子比特的区域

- 用于将信号传输到量子比特的方法

- 用于运行程序和发送指令的经典计算机

对于某些量子比特存储方法,存储量子比特的装置保持在稍高于绝对值零的温度,以最大程度提高其相干性并减少干扰。其他类型的量子比特装置使用真空室来帮助最大程度地减少振动并使量子比特保持稳定。

可以使用多种方法(包括微波、激光和电压)将信号发送到量子比特。

量子计算机的使用和应用领域

量子计算机不可能在每个方面都比经典计算机快,但在有些领域,量子计算机可能会产生重大影响。

量子模拟

量子计算机在对其他量子系统进行建模时表现非常出色,因为它们在计算中使用了量子现象。这意味着它们可以处理让经典计算机难以应对的系统带来的复杂性和不确定性。可以建模的量子系统示例包括光合作用、超导性和复杂的分子形成。

加密

广泛用于保护数据传输的 Rivest–Shamir–Adleman (RSA) 算法等传统加密面临着整数质因数分解或离散对数等难题。使用量子计算机可更高效地解决其中许多问题。

优化

优化是在给定问题的预期结果和约束条件的情况下找到问题最佳解决方案的过程。在科学和行业领域,关键决策主要是基于成本、质量和生产时间等因素做出的,而这些因素都可以进行优化。通过在经典计算机上运行量子衍生优化算法,可以找到以前无法实现的解决方案。这可以帮助我们找到更好的方法来管理复杂的系统,例如交通流、登机口分配、包裹配送和能源存储。

量子机器学习

经典计算机上的机器学习正在彻底改变科学和商业领域。不过,训练机器学习模型的计算成本高昂,因而限制了该领域的范围和发展。为了加快这一领域的发展,我们正在探索用于设计和实现可加快机器学习速度的量子软件的方法。

搜索

1996 年开发的一种量子算法极大地加速了对非结构化数据搜索的解决方案,与传统算法相比,其搜索步骤更少。

发展轨迹

一般认为量子计算机仍处于研究阶段。然而2011年5月11日加拿大的D-Wave 系统公司发布了一款号称“全球第一款商用型量子计算机”的计算设备“D-Wave One”,含有128个量子位。2011年5月25日,洛克希德·马丁同意购买D-Wave One。南加州大学洛克希德马丁量子计算机研究中心(USC-Lockheed Martin Quantum Computation Center)证明D-Wave One不遵循经典物理学法则的模拟退火(simulated annealing)运算模型,而是量子退火法。该论文《可编程量子退火的实验特性》(Experimental Signature of Programmable Quantum Annealing)发表于《自然通信》(Nature Communications)期刊。该量子设备是否真的实现了量子计算目前还没有得到学术界广泛认同,只能有证据显示D-Wave系统在运作时逻辑不同于传统计算机。

2013年5月D-Wave 系统公司宣称NASA和Google共同预定了一台采用512量子位的D-Wave Two量子计算机。该计算机运行特定算法时比传统计算机快上亿倍,但换用算法解相同问题时却又输给传统计算机,所以实验色彩浓厚并延续了学术界争论。

2013年5月,谷歌和NASA在加利福尼亚的量子人工智能实验室发布D-Wave Two。

2015年5月,IBM在量子运算上获取两项关键性突破,开发出四量子比特型电路(four quantum bit circuit),成为未来10年量子计算机基础。另外一项是,可以同时发现两项量子的错误类型,分别为bit-flip(比特翻转)与phase-flip(相位翻转),不同于过往在同一时间内只能找出一种错误类型,使量子计算机运作更为稳定。

2015年10月,新南威尔士大学首度使用硅制作出量子闸。

2016年8月,美国马里兰大学学院市分校发明世界上第一台由5量子比特组成的可编程量子计算机。

2017年5月,中国科学院宣布制造出世界首台超越早期经典计算机的光量子计算机,研发了10比特超导量子线路样品,通过高精度脉冲控制和全局纠缠操作,成功实现了目前世界上最大数目的超导量子比特多体纯纠缠,并通过层析测量方法完整地刻画了十比特量子态。[21]此原型机的“玻色取样”速度比国际同行之前所有实验机加快至少24000倍,比人类历史上第一台电子管计算机(ENIAC)和第一台晶体管计算机(TRADIC)运行速度快10-100倍,虽然还是缓慢但已经逐步跨入实用价值阶段。

2017年7月,美国研究人员宣布完成51个量子比特的量子计算机模拟器。哈佛大学米哈伊尔·卢金(Mikhail Lukin)在莫斯科量子技术国际会议上宣布这一消息。量子模拟器使用了激光冷却的原子,并使用激光将原子固定。

2018年6月,英特尔宣布开发出新款量子芯片,称使用五十纳米的量子比特做运算,并已在接近摄氏零下273.15度的绝对零度中进行测试。

2019年1月8日,IBM在消费电子展(CES)上展示了已开发的世界首款商业化量子计算机IBM Q System One[26]但其基本只有实验研究价值,没有超越传统计算机的实用性。同年10月谷歌制造的一台“悬铃木(Sycamore)”量子计算机声称超越了传统计算机实现量子霸权,而隔日IBM投书称该计算机是宣传性哗众取宠产品,[27]运作方式依然没有超出目前量子科技范围,其只在特定条件特定问题下的一种实验问题结果[28],而传统计算机只要更换算法就能达到同样效果,成本还更低、正确率更高,这被科技期刊称为“量子门”争议事件,德州大学奥斯汀分校理论计算机科学家斯科特·阿伦森则保守中立认为,虽谷歌成果实用有限“但假设它是成立的,那么科学象征成就是巨大的。”因为代表量子计算机取代传统计算机有其可能。谷歌首席首席执行官 Sundar Pichai 的立场则是承认这次实验没有实用性但具有莱特兄弟第一架飞机意义,证实飞机此一概念是有可能。

2020年8月,Google的研究团队发表论文,公布其研发的Sycamore量子处理器成功模拟了化学反应,打破了过去化学量子计算规模的记录。虽然模拟的是较为基础的氮氢反应,但此项研究证明量子计算机在化学模拟的实用性,研究团队并希望将量子模拟的算法扩大到更复杂更大分子的化学反应中。[29][30]

2020年9月5日,中国科学技术大学常务副校长、中国科学院院士、西湖大学创校校董潘建伟教授在公开课演讲上向公众透露光量子计算机最新进展:已经实现了光量子计算性能超过谷歌53比特量子计算机的100万倍。[31]

2020年12月4日,中国科学技术大学发布使用76个光子进行运算的量子计算机九章,并宣布实现量子优越性。[32]台湾的“微系统暨奈米科技协会”解释说,“九章”所使用到的“玻色子取样机”(Boson sampling)并不同于量子比特计算机,虽能提供通往高速量子计算的快捷方式,但该取样机仅运行1种固定任务,它是由分光镜组成的网络,能将抵达平行输入端口的一组光子转换成由平行输出端口离开的第二组光子,玻色子取样便是用来计算光子输入输出配置之间对应的概率。[33]“玻色子取样机”(Boson sampling)是2011年麻省理工学院的斯科特·阿伦森和亚历克斯·阿基波夫(Alex Arkhipov)所提出的设备,能提供通往高速量子计算的“快捷方式”。玻色子取样是一种替代方案,并不是通用的量子计算。