2020年11月,英伟达推出了A100 80GB新卡。 该芯片是基于英伟达的Ampere图形架构,旨在通过实现更好的实时数据分析,帮助企业和政府实验室更快地做出关键决策。 A100芯片为研究人员和工程师提供了更快的速度和更高的性能,用于人工智能和科学应用。

它提供超过每秒2 terabytes的内存带宽,这使得系统能够更快地将数据提供给GPU。所谓的GPU是英文Graphics Processing Unit的简称(图像处理器),是由数以千计更小、更高效的核心组成的大规模并行计算架构芯片。在专业人士看来,GPU比CPU(中央处理器)“复杂得多”,也更适用于进行密集型数据处理。简言之,GPU芯片就是主要用于人工智能和数据中心的顶级计算芯片。

在人工智能领域,英伟达再次提高了门槛,几乎没有任何竞争对手能够跨越这一障碍。

A100芯片能用来干啥?

在我们熟悉的自动驾驶方面,打个比方,现在我们不是常说自动驾驶算法重要,算法重要的的核心地方是数据量重要,因为海量数据的训练才能让算法更加精准;那么海量数据的快速准确处理学习的时候,这种超算的GPU就能大显身手了。开个玩笑,假如这个时候国内哪家跳出来这个禁令严重影响自己的自动驾驶开发,说明他家自动驾驶就是领先的。

另外我们常说的车路协同,其中路端需要使用就是这些数据处理中心,路端传感器接收到的海量数据,需要数据中心的处理才能有明确的信息,才能指挥路段的协作。

最后现在比较流行的说法“数字孪生(digital twin)”,也就是说所有的现实数据,传输到数据中心进行处理,虚拟仿真,进行预测和优化。打个最流行的比方吧,当前的新冠疫情,假设所有的疫情数据例如感染时间,地点,病情,治疗情况,医院情况等等信息进入超算中心,超算中心可以模拟出疫情发展,那么可以测算出各种疫情处理的方法,而不是各种砖家,领导瞎逼逼了。当然在疫情刚开始的时候我的文章《受新冠疫情影响-全球汽车厂暂时关闭工厂潮涌现》中借用的图片就是美国著名霍普金斯大学的大数据图,所以有可能美国人已经数字孪生一遍了。

当然随着万物互联,各方数据的集合处理都离不开数据超算中心,例如医疗诊断设备的片子可以大数据处理用来AI诊疗等等,所以这些超算芯片与我们生活息息相关,而不是停留在科学世界里面。

困住中国自动驾驶进步的A100芯片

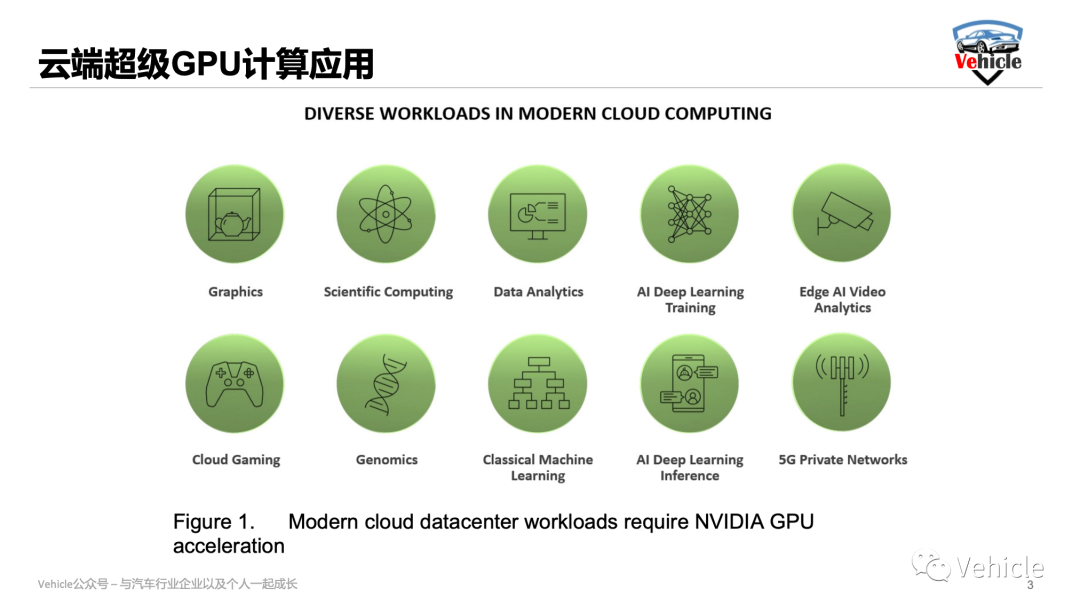

目前美国的限制目录里主要针对AMD的MI100和MI200,以及英伟达的A100和H100。深圳从事GPU芯片产业研究的相关专家告诉记者,这些芯片并非针对普通消费领域,而是人工智能、深度学习等领域。如自动驾驶、医疗影像设备、智慧安防、边缘计算等与机器深度学习相关的相关领域,这些厂商对英伟达和AMD的高性能GPU芯片需求高涨。

半导体领域的专业人士告诉汽车预言家,目前英伟达和AMD是GPU计算领域公认的全球领导者,其中仅英伟达在数据中心GPU市场占比超过80%,在云端训练市场上占比90%,云端推理市场上占比60%。这两大厂商不仅在GPU领域建立起了一定的专利壁垒,而且它们的议价空间、话语权越来越大。

此外,美国媒体还表示,美国政府通过AMD和英伟达的芯片禁令就是用来遏制中国先进计算发展。甚至高于A100算力的显卡都会受到限制。这对于我国智能汽车发展来说影响巨大。

目前,比亚迪、蔚来、理想、小鹏等都大量采用英伟达和AMD的芯片,用于智能驾驶和智能座舱。甚至有些车企还基于英伟达A100打造自动驾驶训练中心。

其中,蔚来是最早官宣和英伟达A100的合作。2021年底,蔚来宣布将采用英伟达A100 80G和Mellanox InfiniBand ConnectX-6打造超级计算机。这个超级计算机主要是用于自动驾驶训练。

今年8月2日,小鹏汽车联合阿里云,宣布在内蒙古乌兰察布建成中国最大的自动驾驶智算中心“扶摇”,用于自动驾驶模型训练。其数据中心的GPU部分很有可能是英伟达A100。随着限制法令效应显现,如果中国智能车企不能采取更好应对措施,中国智能车企的自动驾驶软件学习的效率会随着技术的更新相对于国外企业变得越来越慢。

目前中国智能汽车发展规模居全球之冠,同时不可忽略的是核心芯片严重受制于人。根据国家统计局公布的《2021年国民经济和社会发展统计公报》显示,2021年集成电路进口6335亿个,同比增长16.9%,进口金额为27935亿元,同比增长15.4%,成为我国进口金额最大的商品类型。

而根据IC Insights的统计显示,2021年国内汽车芯片自给率只有5%。从细分领域来看,我国在汽车计算、控制类芯片的自主率不到1%,传感器4%,功率半导体8%,通信3%,存储器8%。

对于中国芯片受制于人一事,同济大学汽车工程学院教授朱西产在接受汽车预言家采访时表示,相比于消费级、工业级,车规级芯片的安全性和稳定性要求高、研发周期长、技术门槛高、资金投入大,其中车规级MCU最长交付期达52周。因此,发展车规级芯片面临的挑战也更多。

朱西产强调,西方应对中国高精尖芯片产业往往采取两种手段,一是加紧限制,遏制中国芯片产业发展,以便西方芯片产业谋取高额利润;另外就是当中国芯片产业发展稍微抬头时,西方便采用芯片倾销手段,目的就是通过价格战让中国芯片市场处于无利可图空间。进一步打压中国芯片制造投入信心。

而随着中美博弈脱钩化越来越明显,有智库人士表示,为了摆脱“卡脖子”情况,中国自主掌握芯片技术决心更加强烈,国产芯片替代计划正在提速。

A100 有多强悍?

相比于英伟达前一代的 Volta GPU,A100 的性能提升了 20 倍,非常适合于人工智能、数据分析、科学计算和云图形工作负载。该芯片由 540 亿个晶体管组成,打包了第三代 Tensor 核心,并具有针对稀疏矩阵运算的加速功能,对于 AI 推理和训练来说特别有用。此外,每个 GPU 可以划分为多个实例,执行不同的推理任务,采用 Nvidia NVLink 互连技术可以将多个 A100 GPU 用于更大的 AI 推理工作负载。

然而,这些在 H100 出现之后显得略有不足了。在今年春季的发布会中,黄仁勋发布了面向高性能计算(HPC)和数据中心的下一代 Hopper 架构,搭载新一代芯片的首款加速卡被命名为 H100,它就是 A100 的替代者。

H100 是一款针对大模型专门优化过的芯片,使用台积电 5nm 定制版本制程(4N)打造,单块芯片包含 800 亿晶体管。同时也是全球首款 PCI-E 5 和 HBM 3 显卡,一块 H100 的 IO 带宽就是 40 terabyte 每秒。

Transformer 类预训练模型是当前 AI 领域最热门的方向,英伟达以此为目标专门优化 H100 的设计,提出了 Transformer Engine,集合了新的 Tensor Core、FP8 和 FP16 精度计算,以及 Transformer 神经网络动态处理能力,可以将此类机器学习模型的训练时间从几周缩短到几天。

针对服务器应用,H100 也可以虚拟化为 7 个用户共同使用,每个用户获得的算力相当于两块全功率的 T4 GPU。此外,H100 还实现了业界首个基于 GPU 的机密计算。

基于 Hopper 架构的 H100,英伟达还推出了机器学习工作站、超级计算机等一系列产品。8 块 H100 和 4 个 NVLink 结合组成一个巨型 GPU——DGX H100,一共有 6400 亿晶体管,AI 算力 32 petaflops,HBM3 内存容量高达 640G。

与此同时,得益于与 Equinix(管理全球 240 多个数据中心的全球服务提供商)的合作, A100 和 H100 的新型 GPU 通过水冷方式来节省用户的能源成本。使用这种冷却方法最多可以节省 110 亿瓦时,可以在 AI 和 HPC 推理工作中实现 20 倍的效率提升。